使用 DeepSeek + Continue + Cline 搭建你的超级 AI 编程助手,模型质量媲美 Cursor,堪称国产最佳平替。

代码补全:Continue

Continue 是一款开源的 AI 编程辅助工具,支持在 VSCode 中集成多种 AI 模型,包括 DeepSeek Coder,在 VSCode 扩展市场中搜索可安装。

远程调用 API

远程调用 API 输入付费使用模型,速度比较快,推荐。以下是具体步骤:

1、获取 DeepSeek API 密钥

访问 DeepSeek 开放平台(https://platform.deepseek.com/api_keys),创建并保存 API 密钥。

2、配置 Continue 插件

打开 Continue 插件的配置文件,添加 DeepSeek Coder 模型配置,填入 API 密钥。示例配置如下:

{

"models": [

{

"title": "DeepSeek Coder",

"model": "deepseek-coder",

"contextLength": 128000,

"apiKey": "<YOUR_API_KEY>",

"provider": "deepseek",

"systemMessage": "你是一个专业的软件开发助手,请使用中文回答所有问题。"

}

]

}3、配置自动补全

打开 Continue 插件的配置文件,示例配置如下:

{

"tabAutocompleteModel": {

"title": "Tab Autocomplete Model",

"provider": "deepseek",

"model": "deepseek-coder",

"apiKey": "<YOUR_API_KEY>",

}

}4、使用功能

安装并配置完成后,可以通过 Continue 插件使用 DeepSeek Coder 的代码补全、代码生成、对话等功能

本地部署模型

如果你希望本地运行 DeepSeek Coder 模型,可以使用 Ollama 框架,虽然可以白嫖,但是本地机器性能一般不允许,不推荐使用。以下是具体步骤:

1、安装 Ollama

从 Ollama 官网(https://ollama.com)下载并安装。

2、下载 DeepSeek Coder 模型

在终端中运行以下命令下载模型:

# 默认为 1.3b 个参数,大小为 776 MB

ollama pull deepseek-coder

# 使用 6.7b 个参数,大小为 3.8 GB

ollama run deepseek-coder:6.7b

# 使用 33b 个参数,大小为 19 GB

ollama run deepseek-coder:33b3、配置 Continue 插件

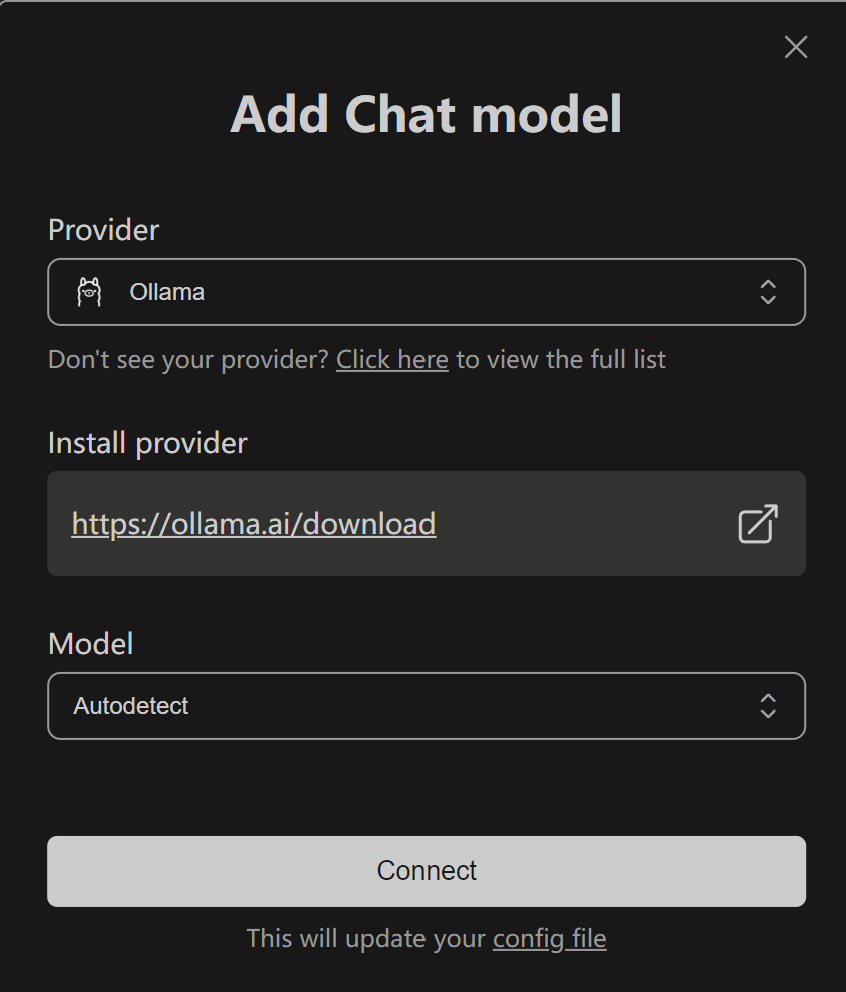

在 Continue 插件中配置本地模型,直接添加 Ollama 即可,Continue 可以自动觉察已经安装好的模型。

4、使用功能

本地部署后,可以在 VSCode 中使用 DeepSeek Coder 的功能,但性能取决于本地硬件配置。

任务执行:Cline

Cline 是一个能够使用命令行和编辑器的自主编码代理,可以在你的许可下创建、编辑文件和执行命令等,支持多种 AI 模型,包括 DeepSeek,在 VSCode 扩展市场中搜索可安装。以下是配置 DeepSeek 的步骤:

1、获取 DeepSeek API Key

访问 DeepSeek 的官方网站(如 DeepSeek)并注册账号。

在账号设置中生成 API Key。

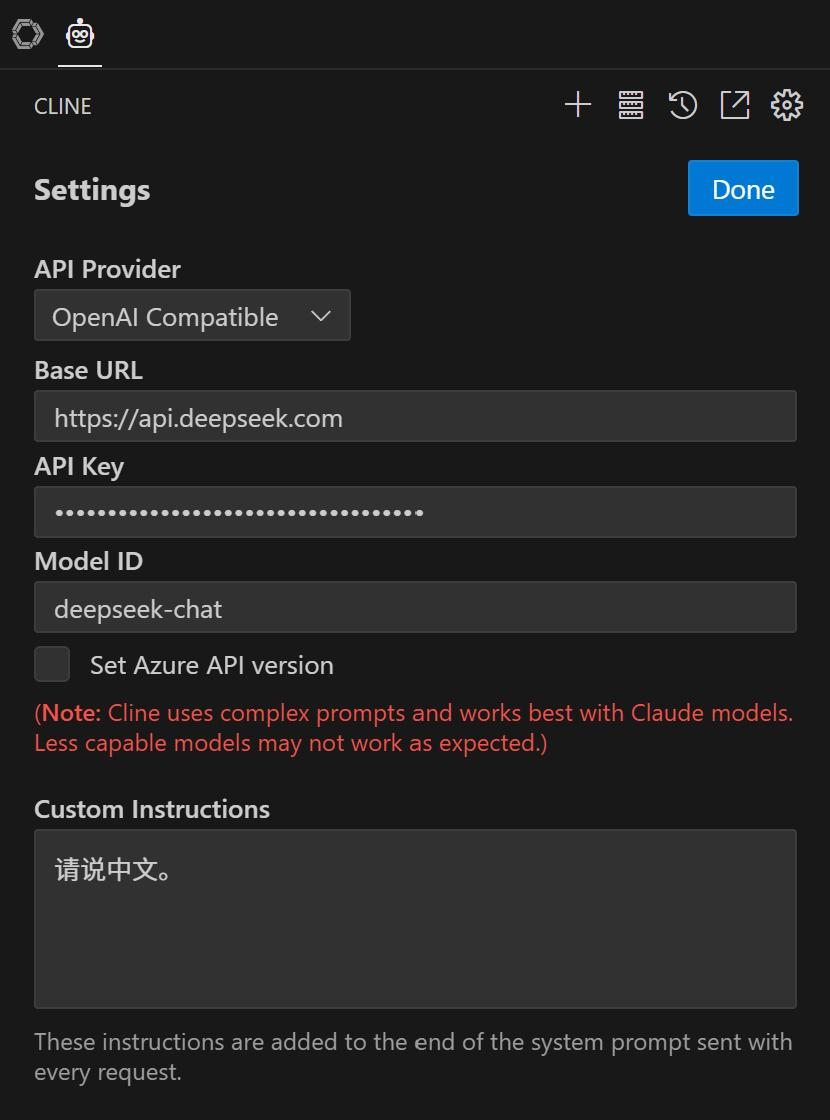

2、配置 Cline

打开 Cline 设置页面,在 Cline 面板左上角可以找到。

在设置页面中,找到 “API Provider”,选择 “OpenAI Compatible”。

在 “Base URL” 中,输入 DeepSeek 的 API 地址(例如 “https://api.deepseek.com”)。

在 “API Key” 中,输入你从 DeepSeek 获取的 API Key。

在 “Model ID” 中,输入 DeepSeek 的模型名称(例如 “deepseek-coder“ 或者 “deepseek-chat“)。

3、使用功能

在对话框输入你的任务说明即可开始了,Cline 使用 Token 速度比较快,请注意费用。

总结

这样,你的超级 AI 编程助手就搭建好了,恭喜你正式进入国产第一梯队 🎉。